Seguramente ha escuchado en más de una ocasión hablar sobre el famoso archivo robots.txt. Aunque quizás no tenga claro cuál es su uso.

En el post de hoy hablaremos sobre el archivo robots.txt, su uso y algunos elementos que lo componen.

Pero no se asuste, aunque parezca que puede ser un contenido farragoso y para, por ejemplo, expertos en SEO, nada más lejos, haremos un artículo para que usted y cualquier usuario, pueda entender y adentrarse en el interesante mundo del archivo robots.txt.

¿Qué es y para qué sirve archivo robots.txt?

Vamos a empezar por el principio, con una definición sobre qué es el archivo robots.txt.

Como se imagina es un archivo con una extensión .txt, que sube a su sitio, y tiene la función de indicar a ciertos buscadores, que información no quiere que sus robots indexen, ni muestren en sus resultados.

¿Y por qué le vamos a decir, por ejemplo, a Google que no indexe ni muestre contenido de mi web? Se preguntará, muy sencillo, para impedir, por ejemplo, que acceda a contenido duplicado, como versiones imprimibles de su web.

Si bien es cierto que, aunque usted cree su archivo robots.txt, indicando a los robots de buscadores que X o Y contenido no sea indexable ni rastreable, es te archivo son meras indicaciones, es decir es consultivo, y no garantiza un hermetismo al 100%.

También hay que puntualizar que, aunque los robots de google, conocidos como Googlebots, si hacen caso a estas indicaciones, otros buscadores como Yandex, Altavista o Alltheweb no tienen por qué hacerlo.

¿Y cómo se crea el archivo robots.txt?

Para empezar, tiene que tener acceso a la raíz del dominio y subir dicho archivo (en formato .txt, por supuesto)

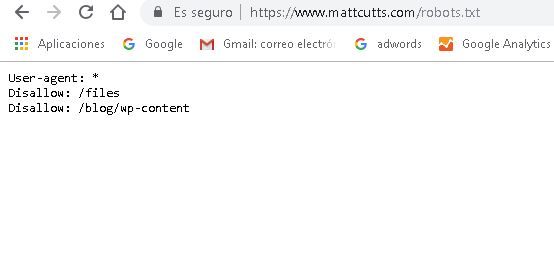

Para que se haga una idea de cómo es un archivo robots.txt, vamos a poner como ejemplo que tiene Matt Cutts.

Comandos que forman un archivo robots.txt

Bien y esto nos lleva al siguiente punto, los elementos o comandos que forman un archivo robots.txt.

Nos vamos a detener en los principales:

User-agent: son los robots y arañas de motores de búsqueda a los que quieres dar instrucciones.

Puedes darle una instrucción a un robot en particular, por ejemplo User-agent: Googlebot o a todos, con el comando User-agent: *

Disallow: si traducimos literalmente esta palabra al castellano, utilizamos rechazar o denegar, así que es fácil entender su uso en un archivo robots.txt.

Cuando introducimos el comando disallow estamos indicando al user agent que no acceda, ni rastreé, ni indexe una URL, directorio o subdirectorio.

Pongamos algunos ejemplos:

- Si queremos bloquear todo el sitio, utilizaremos el comando:

Disallow: /

- Si lo que quiere es bloquear un directorio

Disallow: /https://www.suurl.com/DIRECTORIO/

- También si lo desea podría indicar a los buscadores que quiere eliminar sólo una imagen, pongamos que sólo quiere indicárselo al robot de google

User-agent: Googlebot-Image

Disallow: /imágenes /NOMBREDELARCHIVO.jpg

- Si lo deseara podría incluso bloquear archivos determinados, como los GIFS:

User-agent: *

Disallow: /*.gif$

Allow: el comando allow es el contrario al disallow, en este caso estaríamos indicando a robots o arañas que deben entrar en una URLS, directorio o subdirectorio.

Sitemap: aquí estamos indicando donde está nuestro mapa del sitio en XML.

Crawl-delay: en este caso lo que estamos indicando el número de segundos para cargar entre cada página

Y estos son únicamente algunos ejemplos de comandos, los más utilizados, pero como hemos dicho al principio queríamos que nuestro post fuera un acercamiento para entender la importancia de tener un archivo robots.txt en su site.